人工知能の急速な発展により自動運転カーが現実味を帯びてくることで課題となるのが、「ある人を助けるために他人を犠牲にしてもよいのか」を問う「トロッコ問題」を自動運転カーにどう扱わせるかということ。この課題について、2018年にマサチューセッツ工科大学の研究チームが論文を発表していますが、「第3の選択肢が与えられなかったことで、結果がゆがめられている」と、別の研究者が指摘しています。

Life and death decisions of autonomous vehicles | Nature

http://dx.doi.org/10.1038/s41586-020-1987-4

The Moral Machine reexamined: Forced-choice testing does not reveal true wishes

https://techxplore.com/news/2020-03-moral-machine-reexamined-forced-choice-reveal.html

「トロッコ問題」は、哲学者フィリッパ・フットの提起した思考実験で、「暴走した路面電車の行く先に5名の作業員がいる。途中の分岐器を切り替えれば5人を救うことができるが、その先には別の作業員1名がいる。5名を救うために1名を犠牲にすることは許されるのか」というもの。

人工知能の進化により課題となってくるのが、この種の倫理的問題に対して機械がどのような決定を下すのかという点です。マサチューセッツ工科大学の研究チームは、機械の行動を導く倫理的原則についての社会的な期待を定量化する試みとして、オンライン実験プラットフォーム「Moral Machine」で、233の国と地域から、合わせて4000万件のデータを収集しました。

自動運転カーが絶対に人を殺す状況になったとき誰を犠牲にすればいいと思っているかがわかる「Moral Machine」 - GIGAZINE

その結果として見えてきたのは「人ではなく動物を轢く」「若者ではなく老人を轢く」「女性ではなく男性を轢く」という傾向でした。

The Moral Machine experiment | Nature

https://www.nature.com/articles/s41586-018-0637-6

今回、ノースカロライナ大学チャペルヒル校のヨハナン・ビッグマン氏とカート・グレイ氏が主張しているのは、マサチューセッツ工科大学の行った実験では、テストを受けた人に「全員を平等に扱う」という第3の選択肢が与えられなかったために、結果がゆがめられた、という内容。

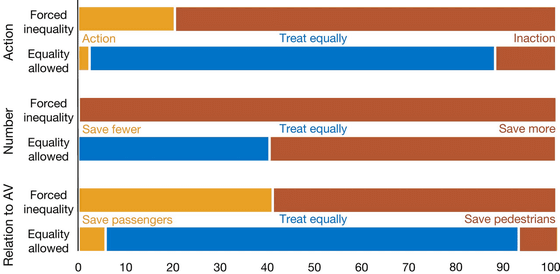

ビッグマン氏とグレイ氏は、「Moral Machine」と同様の設問に「誰が轢かれるか、誰が助かるか」を選ばない第3の選択肢を追加したテストを実施しました。その結果、多くの参加者はほとんどの設問で第3の選択肢を選びました。

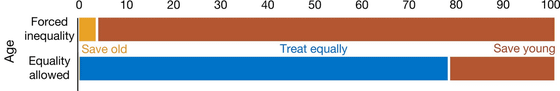

たとえば「若者を轢いて老人を救うか、老人を轢いて若者を救うか」を選ばせる設問の場合を示したのが以下のグラフ。上は2択の場合、下は「平等に扱う」という選択肢を加えた3択の場合の、それぞれの選択率を示していて、2択だと「若者を救う」が90%以上でしたが、3択だと20%ほどに下がり、「平等に扱う」が8割近くを占めています。

「少人数か多人数か」を問う設問については3択にしても「多人数を救う」を選んだ人が多かった(中央のグラフ)ものの、全体的な傾向としては「平等に扱う」を選ぶケースが多数でした。

このことから、研究チームは「強制的に選択させられる問題では、人々の真の願いは明らかにならない」と述べています。

この記事のタイトルとURLをコピーする

"選択肢" - Google ニュース

April 02, 2020 at 02:22AM

https://ift.tt/2wRLeWC

「トロッコ問題」で強制的に選択肢を選ばせると「本当にどうしたいか」が見えてこないという指摘 - GIGAZINE

"選択肢" - Google ニュース

https://ift.tt/369mxRc

Shoes Man Tutorial

Pos News Update

Meme Update

Korean Entertainment News

Japan News Update

No comments:

Post a Comment